Как соцсети с помощью манипуляций формируют нашу информационную повестку

©Federico Gambarini/ DPA/ Vostock Photo

В 1861 году по обнародовании императорского Манифеста «О Всемилостивейшем даровании крепостным людям прав состояния свободных сельских обывателей» Николай Некрасов написал стихотворение «Свобода» (опубликовано в 1869-м):

Знаю, на место сетей крепостных

Люди придумали много иных

Так!.. но распутать их легче народу.

Муза! с надеждой приветствуй свободу!

Поэт, щедро расставляя восклицательные знаки, не мог тогда помыслить, что через полторы сотни лет по миру вольготно раскинутся социальные сети, которые будут формировать нашу информационную повестку и манипулировать нашим к ней отношением.

Кто пускает пузыри?

Формирование информационного пространства не обязательно связано с манипуляцией. Но оно в любом случае ограничено хотя бы нашими физическими возможностями.

В 2011-м вышла книга известного интернет-активиста Илайи Парайзера «Пузырь фильтров: что Интернет скрывает от вас?» (Стараниями отечественных переводчиков автор получил женское имя Эли, а слово «пузырь» превратилось в «стену»). Представляя свою концепцию на культовой технологической конференции TED, Парайзер процитировал Марка Цукерберга: «Белочка, которая прямо сейчас умирает перед вашим домом, гораздо релевантнее для вас, чем то, что кто-то там умирает в Африке». Вот рекомендательные системы и стараются услужить. Используя огромный массив знаний о нас, наших действиях, наших предпочтениях, наших друзьях и их интересах, они создают информационные «пузыри», внутри которых мы вынужденно потребляем поставляемый контент. Через несколько лет после выхода книги ведущие платформы признали, что проблема действительно существует, и объявили, что работают над повышением объективности. Технически это просто – нужно минимизировать персонализацию информационной выдачи. Проблема, однако, в том, что анонимизация сильно подрывает бизнес-модель, где основным коммерческим активом выступают знания о клиенте.

Ничего принципиально нового в «пузырях» нет. СМИ давно известен «эффект эхо-камеры», когда информация, циркулирующая внутри закрытой системы, сама себя усиливает. Психологи описали множество механизмов группового подкрепления и конформности, когда люди меняют свое мнение из-за реального или даже воображаемого влияния со стороны авторитета или группы. Широкую известность получила «спираль молчания» Элизабет Ноэль-Нойман. Ее теория утверждает, что люди, опасаясь социальной изоляции или преследования, избегают высказывать свою точку зрения, если она противоречит доминирующим установкам в их окружении. Ноэль-Нойман критиковали в том числе за политическую ангажированность, а больше – из-за прошлого: в молодости Элизабет успела побыть активисткой национал-социалистического профсоюза студенток и даже встречалась с фюрером, а ее научные и публицистические статьи 1940-х содержат антисемитские высказывания. Однако «спираль молчания» остается весьма популярной, а книга с метафоричным подзаголовком «Общественное мнение – наша социальная кожа» стала почти культовой.

Модерация или цензура?

Даже когда платформы целенаправленно воздействуют на распространяемый контент, речь не всегда идет о манипуляции. Стоит также различать цензуру и модерацию. Некоторые полагают, что разницы нет. А раз так, нет смысла жонглировать словами. Но на самом деле различие есть, и оно принципиальное. Цензурирование – это исполнение закона, который запрещает тот или иной контент. Не только здесь и сейчас или конкретно в Сети интернет, но вообще всегда и везде. Можно обсуждать, насколько закон плох или хорош, но его надлежит исполнять. За нарушение положено наказание.

В западной практике говорят о первичном регулировании – требованиях, которые устанавливают к содержанию, безопасности данных, защите прав интеллектуальной собственности. С другой стороны, платформы дают пользователям возможность публиковать свой контент, и здесь действует вторичное регулирование, касающееся их как посредника и оператора данных. При этом не всё, что допускает закон, является желательным или приемлемым. Модерирование – это выполнение правил. В том числе устанавливаемых самой платформой. В конце концов, это коммерческие предприятия по предоставлению услуг. А пользоваться ими или нет – дело сугубо добровольное. Хотя такой подход ведет к различным этическим и юридическим коллизиям.

Модерация больше касается не содержимого, а того, как оно подается. В публикуемый контент может быть внесена правка. Как правило, техническая. Например, нецензурная лексика будет заменена на звездочки. Редактированием платформы обычно не занимаются. Зато охотно добавляют от себя. Например, превращают авторский контент в гипертекстовой, направляя пользователей на информационные и рекламные ресурсы по своему усмотрению.

Кроме того, контент может быть снабжен комментариями и маркировкой. К частичной маркировке относятся вставки, указывающие статус той или иной организации (например, террористическая) или источника (например, иноагент). К полной – вызывающие множество нареканий попытки обозначать контент как недостоверный. Проблема не в системе и даже не в качестве оценки, сколько в дискриминационной практике, которой придерживаются Twitter, Facebook и другие. Разновидность маркировки – различные рейтинги, присваиваемые пользователям, участвующим в создании и обсуждении контента.

Сам контент можно продвигать или, наоборот, ограничивать, используя различные механизмы приоритизации. Не обязательно блокировать физически, достаточно наложить ограничения на возможности монетизации. Или усложнить доступ – именно так Twitter поступал с постами Дональда Трампа, заставляя пользователей переходить по дополнительным ссылкам. А физическое ограничение – это собственно фильтрация, которая допускает или отклоняет тот или иной контент. При этом решение может зависеть не только от содержания, но и от аудитории. Так работают возрастные ограничения. Так же, по идее, должны работать и географические – платформы все больше сталкиваются с тем, что в различных юрисдикциях действуют свои правила. И либо они будут их соблюдать, либо им придется свернуть там свой бизнес.

Что? Где? Когда?

Вся эта машина может работать централизованно. Но по мере роста объемов контента, числа пользователей и сложности задач модерация становится всё более распределенной. Это также удобно с точки зрения ведения бизнеса.

А вот с точки зрения пользователей гораздо важнее, когда осуществляется модерация: до или после публикации. Пользователи хотят, чтобы все происходило в реальном времени. На деле модерация продолжается всё время жизни контента. Уже опубликованный материал может быть дополнительно промаркирован. Может быть частично или полностью изъят. Может быть ограничен доступ к его комментированию. А содержимое постоянно оценивается на предмет релевантности. Это происходит проактивно, когда платформы сами отслеживают ситуацию, и реактивно, когда они реагируют на жалобы, обращения и предписания.

Пользователям важно, чтобы процесс был прозрачным, понятным. Далеко не всегда платформы уведомляют о том, что контент подвергся модерации и по каким причинам. Это касается не только потребителей, но и собственников контента. Тем более им не всегда дают возможность оспорить то или иное решение. И даже когда такая возможность имеется, воспользоваться ею может быть слишком сложно, долго и затратно. Здесь платформы имеют очевидное нечестное преимущество, которое, однако, не считается неэтичным.

Но и проблем у платформ хватает. О масштабах говорят цифры. В первом квартале этого года Facebook ежедневно посещали около 1,8 млрд человек в сутки. За этот период заблокировано или скрыто почти 2 млрд спамовых сообщений и почти столько же фейковых аккаунтов – эта цифра в последнее время заметно подросла. На таком фоне 107 млн единиц недопустимого или нежелательного контента не выглядят очень страшно. Но это более миллиона сообщений каждый день. Здесь с большим отрывом лидируют взрослая порнография и сексуальный контент, дающие почти 40% нарушений. Около четверти приходится на изображение насилия. По 7–8% дают терроризм, выражение ненависти, оружие и наркотики, детская порнография. Замыкают список кибербуллинг и суициды. Все прочее – в пределах погрешности. Похожая картина и у других платформ.

Невозможно проверить всё и сразу. А постоянно меняющиеся требования еще и вынуждают осуществлять перепроверки задним числом. Бизнес должен постоянно соотносить стоимость решений и риски возможных последствий. Финансовые риски просчитать относительно просто. И зачастую компании дешевле «откупиться» штрафами, чем внедрять решение. Гораздо сложнее предугадать общественную реакцию и политические последствия, которые могут оказаться весьма серьезными. Тут очень показательно то, что происходит вокруг Facebook. Беспрецедентные штрафы, которые получила компания, – это для нее неприятно, но не слишком обременительно. А вот вероятность того, что дорвавшиеся до власти в США демократы именно Facebook выберут на роль мальчика для битья, довольно высока.

Что скажет доктор?

Когда-то модерация осуществлялась вручную. Теперь всё больше работают программы, которые выполняют рутинные операции, дают предварительную оценку, помогают людям принимать решения. В основном это различные алгоритмы машинного обучения, обрабатывающие текст, изображения, звук, видео и метаданные контента с учетом максимально широкого контекста.

С точки зрения эффективности важно, сколько стоит результат и как быстро мы можем его получить. Ручная работа – это всегда долго и довольно дорого. Некоторые алгоритмы тоже весьма затратны с точки зрения вычислительных ресурсов. Не все алгоритмы способны достаточно быстро работать на больших объемах данных. Не все достаточно хорошо справляются с информацией определенного вида.

С точки зрения результативности мы имеем дело с чувствительностью и специфичностью. Точно так же, как, например, при клинических испытаниях. Чувствительность – это процент правильно поставленных диагнозов. Больной определен как больной; запрещенный контент заблокирован. Специфичность – процент правильных отрицательных решений. Больного не записали в здоровые; нормальный контент не помечен, как вредный. Соответственно, мы можем посчитать, сколько будет ложноположительных и ложноотрицательных больных. Исходя из этих показателей, можно оценить, как работает тест. Точность – лишь одна из полутора десятков характеристик.

К сожалению, чувствительность и специфичность очень часто находятся в противоречии. Чем чувствительнее тест, тем менее он специфичен. Это интуитивно понятно: если при каждом чихе мы будем записывать человека в больные, мы, конечно, не пропустим тяжелый случай, но у нас будет много ложных. И наоборот. В жизни приходится принимать решение, исходя из того, что опаснее. Если, скажем, речь идет о действительно тяжелой и заразной болезни, пропускать никого нельзя. На практике можно использовать несколько тестов. Сначала «гребем» всех подозрительных, а потом «отпускаем» тех, кто ни при чем.

Так же, как рыболовная сеть, социальная отцеживает и объячеивает контент. При отцеживании косяк рыбы обметывается неводом или тралом, после чего улов вытаскивают, а вода стекает. При объячеивании рыба запутывается в сетях жаберными крылышками. И чем сильнее пытается освободиться, тем крепче попадает в сети.

- Политика

С.С.Сулакшин Самое интересное

С.С.Сулакшин Самое интересноеПодпиши петицию: С.Сулакшин: «Президент Путин, дай России шанс развиваться, уйди в добровольную отставку!»

Степан Сулакшин создал(а) эту петицию, адресованную Путин, Народ России Устройство всех сфер жизни страны, политический режим в стране, его практики управления государством и результаты губительны для России и ее народа. За 20 лет путинизма все стало предельно ясно и безнадежно. Народ вымирает, падает рождаемость и растет смертность. Лучшая часть населения эмигрирует. Экономика деградирует в сырьевую…4 651 - Политика

Русранд Сулакшин С.С.

Русранд Сулакшин С.С.Антироссийский проект путинизма: реконструкция, идеологические и фактические характеристики

Занимаемся мы в университете оппозиции не пропагандой, не агитацией (что только в какой-то мере так, но главная цель не в этом). Занимаемся мы тем, что убеждаем друг друга и помогаем понять, что слово «оппозиция» — слово ответственное и оно отличается от слов: «балаган», «развлекуха», «подставуха», «суррогат», самопиар и «политическая порнография». Мы делаем совершенно иную заявку и последовательно помогаем строить в стране настоящую политическую оппозицию. Правящий режим и правящая группировка в нашей стране, как известно, получила…1 227 - Экономика

Русранд Самое интересное Степан Степанович Сулакшин

Русранд Самое интересное Степан Степанович СулакшинПутинизм и кризис России

Россия вновь наступает на те же грабли. Годы назад, выдвинув математическую модель мирового финансового кризиса, наша научная политическая группировка предупреждала руководство страны, что оно создает модель экономики и государства несуверенного типа, уязвимые для внешнего агрессивного воздействия. Обстоятельный доклад на эту тему в феврале 2009 году — по кризису одов — был подготовлен для Совета Безопасности Российской Федерации, в котором тогда, совместно с его секретарем Николаем…1 695 - Политика

Сулакшин С.С.

Сулакшин С.С.Вступай в борьбу за власть

Уважаемый соотечественник! Благодарим вас за возможную решимость присоединиться к организационно-политическому строительству объединения настоящей общенародной оппозиции Путину и путинизму в рамках организационной инфраструктуры Партии Нового Типа. Наш отличительный принцип состоит в том, что мы не только разоблачаем губительный характер путинизма, но дали профессиональную диагностику способов и причин деградации страны и народа. В ее основе научные методы, модели и методология. Мы не только критикуем путинизм, но мы делаем настоящее профессиональное, конкретное содержательное предложение — что и как…1 052 - Политика

Русранд

РусрандРоссии нужна другая Конституция!

Конституция — это основной закон страны. Существуют Конституции двух типов — первый, к которому относится ельцинско-путинская Конституция, устанавливает право, порядок и институты государственности. В Конституции иного типа кроме права, порядка и институтов задаются основы жизнеустройства во всех сферах жизни. Задаются социальная, экономическая, политическая, гуманитарная модель страны. Новая Конституция команды Сулакшина — именно такого, второго типа. Каким в Конституции будет задано жизнеустройство, — такой жизнь в стране и будет. Если…377 - Политика

Русранд Самое интересное Степан Степанович Сулакшин

Русранд Самое интересное Степан Степанович СулакшинПутинизм должен исчезнуть! Вызовы оппозиции гибельному курсу России

Автор и его товарищи много усилий приложили для мобилизации в стране реальной политической оппозиции путинизму, но задача создания профессиональной оппозиции, способной взять на себя ответственность за страну, дело трудное, объемное и длительное. Ее решение только еще предстоит. Поэтому мы открыли Университет оппозиции. Это цикл публичных занятий, объединяющей темой которого является политический проект реальной оппозиции, ее политическая Программа. Простой на первый взгляд вопрос — да чего там, за вечер…433 - Общество

Русранд Самое интересное Степан Степанович Сулакшин

Русранд Самое интересное Степан Степанович СулакшинСемь «П». Программа: платформа, проблемная повестка, проект, план, прогноз

Центральная и сквозная тема наших занятий в Университете оппозиции — разбор политической программы — что это такое? Многим кажется, что политическая оппозиция, её роль, миссия и активная повестка демонстрируется в нашей стране, например, Левым фронтом Сергея Удальцова, активно организующего уличные акции; КПРФ с их митингами; был период, когда Навальный со своим политическим проектом будоражил страну множеством митингов по стране и несогласованными, и рискованными митингами в центре Москвы. То есть…176 - Политика

Русранд Самое интересное Степан Степанович Сулакшин

Русранд Самое интересное Степан Степанович СулакшинКорни и истоки «Программы Сулакшина»

Прежде чем подойти к разбору самой «Программы Сулакшина» сделаем несколько необходимых экскурсов. Начнем немного необычно, с отвлеченной истории, описанной Джеком Лондоном в его романе «Мартин Иден». Роман о судьбе талантливого человека в условиях жестокого американского капитализма начала двадцатого века, похожего на нынешнюю Россию с его императивами: выживай кто как может, а если не можешь выжить, погибай! Герой романа, ставший в итоге знаменитым, популярным, почитаемым и модным…166

- Общество

Редакция "Народного Журналиста"

Редакция "Народного Журналиста"Китайская угроза: реальная и мнимая, китаист Николай Вавилов

0:05 – память поколений о конфликте на Даманском живет в российском обществе 01:45 – реальная угроза Китая для СССР 04:45 – угрозы Китая сегодня: реальна ли демографическая угроза? 10:05 – оценка военной угрозы Китая для России 19:05 – какие политические силы хотят конфликта с Россией 27:00 – необходимость рационального ограничения китайских инвестиций на Дальнем Востоке…22.12.2020 1:15 10 - Общество

Редакция "Народного Журналиста"

Редакция "Народного Журналиста"Как отличать правду от краснобайства?

Фото: источник Прислушиваться к политическому языку, конечно, надо, но этого маловато. Надо ещё его правильно трактовать. Язык всегда являлся основополагающим явлением для точного понимания образа мысли его носителей. Но в с ускорением «развития» общества также ускорилась смысловая «двойственность» почти всех, ранее однозначно трактуемых терминов. В окружающей нас «абракадабреизобырвалга» (очень любимой во властных структурах), стало заметно…22.12.2020 0:43 6 - Общество

Алексей Напылов

Алексей НапыловАвария на «Томете»: некомпетентность или спланированная диверсия?

В последние две недели на ООО «Томет» происходят почти детективные события. «Томет», в который в прошлом десятилетии были незаконно выведены агрегат аммиака и производство метанола из ПАО «Тольяттиазот», пытались обанкротить владельцы ТоАЗа Махлаи. В 2019 году скрывающиеся за рубежом Махлаи были заочно осуждены к реальным тюремным срокам за мошенничество в особо крупном размере. Приговор вступил…7 - Общество

Игорь Витальевич Олин Русранд

Игорь Витальевич Олин РусрандА вы ищите виноватых!

Друг поделился впечатлением из Петербурга, находящегося в ситуации ковидной катастрофы. С товарищами из небольшой общественной организации они пытались привлечь местных жителей в волонтёрское движение по оказанию помощи горожанам, кто оказался в трудной жизненной ситуации: болеет, на карантине, нуждается в доставке лекарств, продуктов и т. п. За немалый срок обошли множество квартир, в которых проживает примерно 17 тыс. человек. «Сколько откликнулось человек?», — спросил он меня. Я почти угадал — 14. Точнее, не угадал,…16 - Общество

Русранд

РусрандСанитарка с «зарплатой 116 тысяч рублей» назвала свой реальный заработок

Санитарка из кольской больницы Наталья Козырева, которая на пресс-конференции Владимира Путина пожаловалась президенту на отсутствие «коронавирусных» надбавок, и зарплата которой, по утверждению местных властей, составила 116 тысяч рублей, назвала свой реальный заработок. Как пишет издание «Подъем», он сильно отличается от озвученной чиновниками суммы — за месяц она получила 29 тысяч рублей. «Я сама в шоке от цифры 116 тысяч и 77 тысяч. Я знаю правду, и человек, который говорит правду, не боится, —…11 - Общество

Лилия Караева

Лилия КараеваХудожественный фильм «Роскосмоса» пообещали «не пропустить»

Roscosmos.ru Вице-премьер Юрий Борисов не допустит финансирование за бюджетные деньги фильма «Роскосмоса». Он объяснил, что выход картины вызовет вопросы контролирующих органов. Об этом вице-премьер сказал в интервью РБК. Он считает, что фильм под названием «Вызов» «абсолютно точно» должен быть создан не за бюджетные деньги. «Я вам гарантированно могу сказать, что пока я на этом посту, я…7 - Общество

Артур Иванов

Артур ИвановРоссияне назвали размер идеальной пенсии

Большинство россиян хотели бы получать пенсию размером 30 000 — 45 000 рублей. Об этом говорится в исследовании финансовой онлайн-платформы Webbankir. Пенсию в 45 000 рублей хотели бы получать 46,6% опрошенных, ещё 29,1% россиян согласны на пенсию в 30 000 рублей. 22,1% заявили, что пенсия их мечты — больше 45 000 рублей. Только 1% заявили, что им…3 - Общество

Дмитрий Колезев

Дмитрий КолезевСколько стоит информация о вас и ваших близких

За 3 тыс. рублей продаются данные из баз МВД, за 40 тыс. можно сделать поддельную сим-карту На черном рынке за скромную плату доступна любая информация, попавшая в какие-либо крупные базы данных — как государственные, так и корпоративные. За несколько тысяч рублей можно получить детализацию звонков или данные о пересечении границы. It’s My City ознакомился с одним из прайс-листов…28 - Общество

Камилла Дадашова

Камилла ДадашоваРоссийская пшеница застревает в экспортных портах

Фото отсюда В России начались сложности с отправкой пшеницы по текущим контрактам, рассказали «Коммерсанту» три источника на рынке. Простой повышает риски срыва поставок и вынуждает переплачивать за фрахт, репутация страны на мировом рынке зерна оказалась под угрозой. Один собеседник газеты в крупной компании-экспортере сообщил, что таможенная служба внезапно стала задерживать грузы для досмотра на срок до 10…30 - Общество

Валерий Бурт

Валерий БуртСеанс гипноза от президента России

Фото: kremlin.ru Владимир Путин рассказал россиянам, как им живется. И обрисовал перспективы Уверен, что президент России, кроме массы удивительных и даже сверхъестественных качеств, владеет незаурядным даром гипноза. Он способен завораживать, вводить в ступор не сотню-другую людей, как незабвенный Кашпировский, а десятки миллионов. До вчерашней большой пресс-конференции Владимира Путина автор этих строк был уверен, что положение…43 - Общество

Артур Иванов

Артур ИвановНабиуллина высказалась против государственного сдерживания цен

Глава Центробанка (ЦБ) Эльвира Набиуллина высказалась против государственного сдерживания цен на продукты. По её словам, это крайняя мера, которая должна применяться после рыночных механизмов. «Я в принципе не очень поддерживаю введение административных мер. Я понимаю, что их можно рассматривать как крайнюю меру, когда были использовано, исчерпано влияние рыночных механизмов. Но в данном случае просто рыночные…31 - Общество

Игорь Лесовских

Игорь ЛесовскихДела о защите чести полицейских всё чаще рассматривают в судах

В России сотрудники полиции испытывают проблемы с защитой своих трудовых прав. Ежегодно покидают службу с волчьим билетом десятки полицейских. Переломный момент произошёл недавно в Курске, где суд встал на защиту полицейской четы, уволенной за совершение «порочащего честь МВД» проступка. По мнению экспертов, отсутствие чётких критериев таких проступков позволяет легко зачищать нелояльных сотрудников. Важное для рядовых…20.12.2020 9:22 27 - Общество

СНЖ Софья Суворова

СНЖ Софья СувороваМоя полиция меня бережет?..

Фото отсюда Недавно произошло очередное «интересное» событие: Госдума приняла в первом чтении законопроект о расширении полномочий полиции «МОСКВА, 8 декабря. /ТАСС/. Госдума во вторник поддержала в первом чтении резонансный законопроект о новых полномочиях полиции, определяющий в том числе перечень оснований, по которым полицейские могут вскрывать автомобили. Инициатива, внесенная в Госдуму правительством РФ в мае, одновременно…73 - ОбществоНаталья Залевская

Элита журналистики: памяти погибших военкоров ДНР

Фото: Наталья Залевская На днях в ДНР поминали погибших военкоров, доносивших до всего мира правду о донбасской войне. В конференц-зале Донецкого университета, где проходило мероприятие, кроме официальных лиц республики и представителей СМИ, я заметила много совсем молодых журналистов, только осваивавших путь в профессию. С нескрываемым интересом они следили за тематическими сюжетами республиканского Министерства информации о…19.12.2020 8:20 25 - Общество

Алексей Захаров

Алексей ЗахаровРоссия справляется плохо с эпидемией

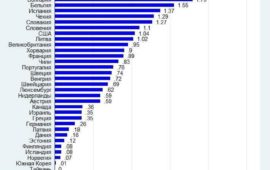

Для 35 стран я оценил избыточную смертность в 2020 году из расчета на тысячу человек населения [1]. Россия на третьем месте, впереди лишь Италия и Польша. Напомню, в нашей стране избыточная смертность составляет примерно 280 тысяч человек. Я решил взять именно эту величину [избыточную смертность] по двум причинам. Во-первых, рапортуемое число смертей от Ковид иногда…19.12.2020 1:37 31 - ОбществоНадежда Октябрьская СНЖ

С ума можно сойти

Фото: «ВКонтакте». В Томске торжественно открыли колонку с водой «Ну это очень много. Можно было бы и пять, цифра круглая, но семь — многовато. Если семь лет работать с полной отдачей, с ума можно сойти». Такое заявление сделал Владимир Владимирович Путин на встрече со своими доверенными лицами в далеком 2004 году. С тех пор президентский срок был увеличен…46 - Общество

Русранд Степан Степанович Сулакшин

Русранд Степан Степанович СулакшинКАК ПОДНЯТЬ ДЕТЕЙ ПРИ ТАКОЙ ЖИЗНИ? #Сулакшин #Эксперты АКТУАЛЬНЫЙ РАЗГОВОР ◄18.12.2020►

Россию настигает подлинная демографическая катастрофа — уже какой год стремительно падает рождаемость. Случайно ли это? Что должно делать и не делает государство, невзирая на разрекламированный материнский капитал? Присоединяйтесь к беседе. Комментируйте, приводите свои примеры и факты, распространяйте. Ведущий проф. С.С.Сулакшин. Тема выпуска: КАК ПОДНЯТЬ ДЕТЕЙ ПРИ ТАКОЙ ЖИЗНИ? Приходите на канал Центра Сулакшина в youtube.55 - Общество

Сергей Сухачев

Сергей СухачевКак соцсети с помощью манипуляций формируют нашу информационную повестку

©Federico Gambarini/ DPA/ Vostock Photo В 1861 году по обнародовании императорского Манифеста «О Всемилостивейшем даровании крепостным людям прав состояния свободных сельских обывателей» Николай Некрасов написал стихотворение «Свобода» (опубликовано в 1869-м): Знаю, на место сетей крепостных Люди придумали много иных Так!.. но распутать их легче народу. Муза! с надеждой приветствуй свободу! Поэт, щедро расставляя восклицательные знаки,…42 - Общество

Марьям Ибрагимова

Марьям ИбрагимоваВ России готовятся к протестам? За блокировку улиц будут сажать в тюрьму до 10 лет

Фото: gov.karelia.ru В России могут принять законопроект, позволяющий сажать граждан в тюрьму за умышленное блокирование улиц. Комитет ГД по госстроительству и законодательству уже посоветовал Госдуме принять документ в первом чтении, так как он направлен на обеспечение безопасности движения. К уголовной ответственности могут привлечь за умышленную блокировку объектов транспортной инфраструктуры и перекрытие дорог и улиц, если…43 - Общество

Александр Берберов

Александр БерберовСходим с ума… Но меньше других!

Россия оказалась одной из самых вменяемых среди стран белой расы — такие данные показал социологический опрос, завершенный в декабре исследовательским холдингом «Ромир» и международным сообществом исследовательских компаний GlobalNR. Мы сошли с ума — но меньше других: 71% опрошенных россиян считает, что традиционные половые роли для мальчиков и девочек лучше всего подходят для общества. А 29%…56 - Общество

alexey43

alexey43Цирквачи вторника

Депутаты внесли в Госдуму законопроект, которым предлагается предоставить детям сотрудников Росгвардии и органов внутренних дел преимущественное право зачисления в вузы, подведомственные МВД России и Росгвардии, следует из базы данных нижней палаты парламента. Авторами законопроекта выступили глава комитета ГД по информполитике Александр Хинштейн, глава комитета по образованию и науке Вячеслав Никонов и глава комитета по безопасности Василий Пискарев….53 - Общество

Михаил Днепровский

Михаил ДнепровскийСуд отклонил исковые требования крымского главврача о защите чести и достоинства

Ленинский районный суд Республики Крым рассмотрел в открытом судебном заседании гражданское дело по иску главврача ЦРБ к корреспонденту сайта «Антифашист» и врачу-реаниматологу о защите чести, достоинства и деловой репутации. Суд первой инстанции постановил: в удовлетворении исковых требований Гаптракипова Эдуарда Халиловича — отказать. Ранее истец обратился в суд по поводу публикации статьи «Крымские врачи жалуются на…20 - ОбществоОльга Рязанова

Блогеров и пользователей соцсетей предлагают лишать свободы за клевету

©depositphotos.com Пользователям соцсетей нужно быть осторожнее – Госдума планирует ужесточить наказания за клевету в интернете. За нее можно будет лишиться свободы на два года, а за клеветническое обвинение в совершении тяжких преступлений – и вовсе на пять лет. Эксперты называют предлагаемые санкции несоразмерными, а саму инициативу неактуальной и направленной на запугивание граждан. В середине декабря…26 - Общество

Марина Юршина

Марина ЮршинаДеньги на ветер: аудиторы признали цифровизацию экологии неэффективной

©Shutterstock/Fotodom Ведомства тратят огромные деньги на цифровизацию, которая объявлена стратегически важным вопросом для государства. В частности, миллиарды направляются на создание и эксплуатацию государственных информационных систем (ГИС). Аудиторы Счетной палаты проверили, насколько эффективно расходуются бюджетные средства, выделяемые на ГИС в сфере экологической безопасности. Оказалось, что не очень: данных для качественной работы систем не хватает, функционал и…22 - ОбществоАртур Иванов

Миллиардеры мира за время пандемии разбогатели на $2 трлн

Богатейшие люди мира в 2020 году сумели увеличить свои капиталы, несмотря даже на кризис и пандемию. Совокупное состояние 2200 миллиардеров выросло на $1,9 трлн, а больше всех разбогател Илон Маск. По состоянию на 11 декабря капитал богатейших людей мира оценивался в $11,4 трлн, подсчитал американский Forbes. Это на 20%, или на $1,9 трлн, больше, чем в прошлом…27 - ОбществоРусранд

НОВОСТИ ОТ ПУТИНА И НАШИ ЗАДАЧИ ПО ОБРЕТЕНИЮ ВЛАСТИ #ПрограммаСулакшина — ВСЕРОССИЙСКОЕ СОВЕЩАНИЕ МСК. Присоединяйся

В четверг 17 декабря 2020 в 18-00 МСК на ютуб-канале Центра Сулакшина принимайте участие онлайн-трансляции открытого Всероссийского рабочего совещания актива и сторонников Программы Сулакшина «Настоящий социализм». Реплики и вопросы задавайте в чате. #ПрограммаСулакшина ВСЕРОССИЙСКОЕ СОВЕЩАНИЕ45 - Общество

Русранд

Русранд«Нас просто бросили». Жители Крыма о катастрофических последствиях эпидемии COVID на полуострове

По состоянию на 15 декабря в Крыму официально зарегистрировано 19 634 случая заражения коронавирусом. Но судя по жалобам жителей в соцсетях, реальное число заболевших намного больше, к врачам стоят многочасовые очереди, выписываемых лекарств давно нет в аптеках, мест в больницах не хватает, а фельдшеры отказываются приходить на вызовы, чтобы не заразиться. «НАС ПРОСТО БРОСИЛИ — БОРИТЕСЬ С КОРОНОВИРУСОМ КАК ХОТИТЕ» Людмила Корева, Новогригорьевка Мы живем в селе Новогригорьевка Нижнегорского района. Моему отцу 60,…27 - Общество

Арина Корелина

Арина КорелинаРоссийские власти задумали ввозить мигрантов. Они нужны на стройках

Острую нехватку рабочих рук на российских стройках в очередной раз захотели решить за счёт иностранцев. Минстрой задумал организовать трудовым мигрантам упрощённый въезд и оформление, чтобы закрыть дефицит кадров на стройплощадках. При этом российский рынок труда за пандемию уже лишился до полутора миллионов работников, но идти работать на стройку россияне, несмотря на тяжёлые времена, не хотят….38 - Общество

Марат Селезнев

Марат СелезневКак изменились затраты россиян в условиях пандемии

©depositphotos.com / коллаж Россияне стремительно сокращают непервостепенные расходы. Под нож пошли траты на 90% категорий товаров и услуг. Потребители закупаются впрок, берут еду и лекарства и пытаются порадовать себя доступными цифровыми развлечениями. Все последствия деформации потребительского поведения, которую вызвала пандемия COVID-19, пока еще не просчитаны. Но уже сейчас понятно, что выработанная многочисленными кризисами привычка экономить для…58 - Общество

Анастасия Красильникова

Анастасия КрасильниковаСтрельба по детям в России приравнена к хулиганству

Почему от нападения силовика на 13-летнюю Софию её защищает не полиция, а другие подростки? 5 декабря московский полицейский Иван Князев выстрелил из травматического пистолета в 13-летнюю Софию. В момент совершения преступления 33-летний сотрудник патрульно-постовой службы находился не при исполнении и был изрядно пьян. Князеву не понравилось, что ребенок не ответил на его домогательства. В отношении…49

- Общество

Сергей Сухачев

Сергей СухачевКак соцсети с помощью манипуляций формируют нашу информационную повестку

©Federico Gambarini/ DPA/ Vostock Photo В 1861 году по обнародовании императорского Манифеста «О Всемилостивейшем даровании крепостным людям прав состояния свободных сельских обывателей» Николай Некрасов написал стихотворение «Свобода» (опубликовано в 1869-м): Знаю, на место сетей крепостных Люди придумали много иных Так!.. но распутать их легче народу. Муза! с надеждой приветствуй свободу! Поэт, щедро расставляя восклицательные знаки,…42 - Общество

Сергей Сухачев

Сергей СухачевЧем можно сбивать беспилотники, и в каких ситуациях это разрешается делать

В канун прошлого Нового года американцы, живущие на границе между штатами Небраска и Колорадо, были изрядно взбудоражены непонятными событиями. Десятки очевидцев рассказывали, как на рассвете, откуда ни возьмись, появляются неопознанные дроны, которые, покружив пару часов над полями и дорогами, уносятся за горизонт. Поначалу думали, что ведется топографическая съемка или что-то в этом роде. Но Google,…52

Лента новостей

- Иркутские бизнесмены поставили виселицу у правительства в знак протеста

- Разные новости 21.12.2020

- Новости экономики. 21.12.2020

- Суд оштрафовал иркутскую активистку НОД за пикет в поддержку Путина

- Перелеты омского правительства обойдутся в 7 млн

- Возбуждено уголовное дело об убийстве ученого в Петербурге

- 14 генералов ВС Армении выдвинули премьер-министру Пашиняну ультиматум

- Российские заготовители дорубились до дефицита древесины

- Ради памятника бандеровцам: власти Львова решили полностью снести Монумент славы 20.12.2020 9:28

- Обманутые дольщики приостановили голодовку в Новосибирске из-за угрозы здоровью 20.12.2020 9:13